¿Estás pensando en maneras de obtener datos de Wikipedia para ampliar tu base de datos y responder las dudas de tus usuarios de forma efectiva? En este artículo te contaremos cómo obtener información mediante un raspador de datos para páginas como Wikipedia.

También te contaremos todo acerca de esta actividad, sus fines y cómo obtener un proceso automatizado que te garantice resultados en tiempo récord.

¡Comencemos!

¿Qué es un raspador de datos?

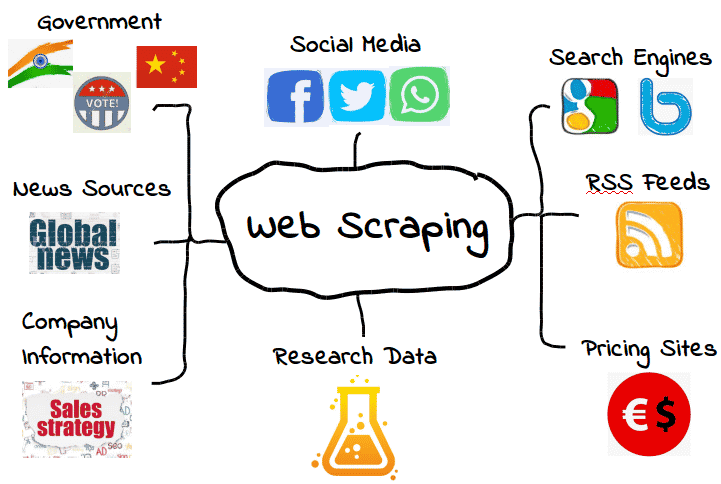

Un raspador de datos o webscraper es un software o programador que se encarga de la extracción de datos de un sitio web. Esta información se recopila y luego se exporta a un formato que sea más útil para el usuario. Ya sea una hoja de cálculo o una API. La actividad realizar por este programa o persona se le conoce como web scraping o raspado de datos.

El raspado de datos es por hoy una de las formas más eficientes y útiles de extraer datos de un sitio web, Esto pues sitios web como Wikipedia pueden contener una gran cantidad de información necesaria para los usuarios en la red.

Precios de acciones, detalles de productos, estadísticas deportivas, contactos de empresas… son algunos de los temas que se pueden extraer con un raspador de datos para Wiki.

Ahora, si tu empresa quisiera acceder a esta información, tendría que usar cualquier formato que use el sitio web o copiar y pegar la información manualmente en un nuevo documento. Por suerte, aquí es donde el raspador de datos puede ayudar.

Raspador web manual O automatizado

Un raspador de datos puede obtener datos manualmente. Sin embargo, en la mayoría de los casos, se prefieren las herramientas automatizadas cuando se extraen datos web, ya que pueden ser menos costosas y funcionar a un ritmo más rápido.

Por otra parte, el web scraping puede llegar a ser una tarea extensa y complicada. Por ello, encontrar un software o raspador de datos de calidad profesional, es fundamental para el éxito en la extracción de datos de Wikipedia en este caso.

No solo este proceso debe provenir de un programa de alto estándar sino que también un proceso automatizado es capaz de ahorrar valioso tiempo a cualquier empresa que busque generar bases de datos de manera rápida y efectiva.

¿Cómo funcionan los raspadores web?

Primero al raspador web se le dará una o más URL para cargar antes de raspar. Luego, el se carga el código HTML completo de la página en cuestión. Los raspadores más avanzados renderizan todo el sitio web, incluidos los elementos CSS y Javascript.

Luego, el raspador extraerá todos los datos en la página o datos específicos seleccionados por el usuario antes de ejecutar el proyecto. Idealmente, el usuario pasará por el proceso de seleccionar los datos específicos que desea de la página. Por último, el raspador web generará todos los datos recopilados en un formato que sea más útil para el usuario.

La mayoría de los web scrapers generarán datos en un CSV u hoja de cálculo de Excel, mientras que los scrapers más avanzados admitirán otros formatos, como JSON, que se pueden usar para una API.

¿Por qué tu empresa necesita un raspador web?

Según lo explicado anteriormente, raspar datos de páginas tan completas como Wiki es sin duda una tarea ardua y compleja. Realizar un proceso manual es ineficiente y además existe una competencia que muy probablemente esté realizando web scraping.

Por ello tu empresa debe ir de la mano con el avance tecnológico y contar con herramientas como un raspador de datos.

En este artículo, queremos también comentar que el web scraping es una actividad totalmente legal. Esto siempre y cuando los datos se utilicen con fines informativos, sus fuentes sean de acceso público (como en el caso de Wikipedia) y que no se utilicen para generarle una competencia directa a la fuente de donde se obtengan estos datos.

Adquiere un raspador de datos para Wiki y automatiza tus procesos

Sin duda que un raspador web automatizado es la opción perfecta para ahorrar costos y aumentar resultados.

Por ello, queremos recomendarte a los mejores. Y hablar de los mejores es hablar de Bright Data: los líderes en el mercado de servicios web.

Bright Data cuenta con un raspador web que se integra a sus redes proxy, líderes de la industria. Además, usa tecnología patentada para desbloqueo de sitios y se adapta a cambios en los sitios; cuando Wikipedia cambie la estructura de su sitio, su plataforma de web scraping también se adaptará.

Aprende más sobre el raspador de datos para Wiki y comienza hoy a recopilar todos los datos que tu empresa necesita, en su totalidad y con rapidez, cumpliendo por completo con las mejores prácticas y las normativas de protección de datos (RGPD y CCPA).